Hoy en día es difícil ignorar la omnipresencia de los datos en nuestra vida diaria, con más de 400 exabytes generados cada día en todo el mundo. Este enorme flujo de información, muchas veces denominado Big Data, está obligando a las empresas a reconsiderar sus sistemas y adaptarse a esta nueva realidad.

Sin embargo, esta revolución de los datos plantea varias preguntas importantes para las empresas:

- ¿Cómo garantizar la fiabilidad de los datos?

- ¿Cómo mantener los sistemas actualizados y controlar los costos?

- ¿Cómo acelerar el despliegue de nuevas plataformas?

- ¿Cómo controlar el acceso a la información estratégica?

Estas preguntas son cruciales porque las respuestas determinarán su capacidad para tomar decisiones informadas, esenciales para seguir siendo competitivos.

El paso a la nube se ha vuelto imprescindible para ganar agilidad a la hora de procesar grandes volúmenes de datos. Con servicios administrados de proveedores como Azure, AWS y GCP, las empresas pueden administrar mejor esta creciente masa de información y centrarse en la innovación. Sin embargo, incluso con la nube, quedan preguntas pendientes:

¿Cómo podemos superar las limitaciones de los métodos tradicionales de gestión de datos, que a menudo son lentos y propensos a errores, para satisfacer las necesidades dinámicas de las empresas modernas?

La revolución DataOps: agilidad y eficiencia

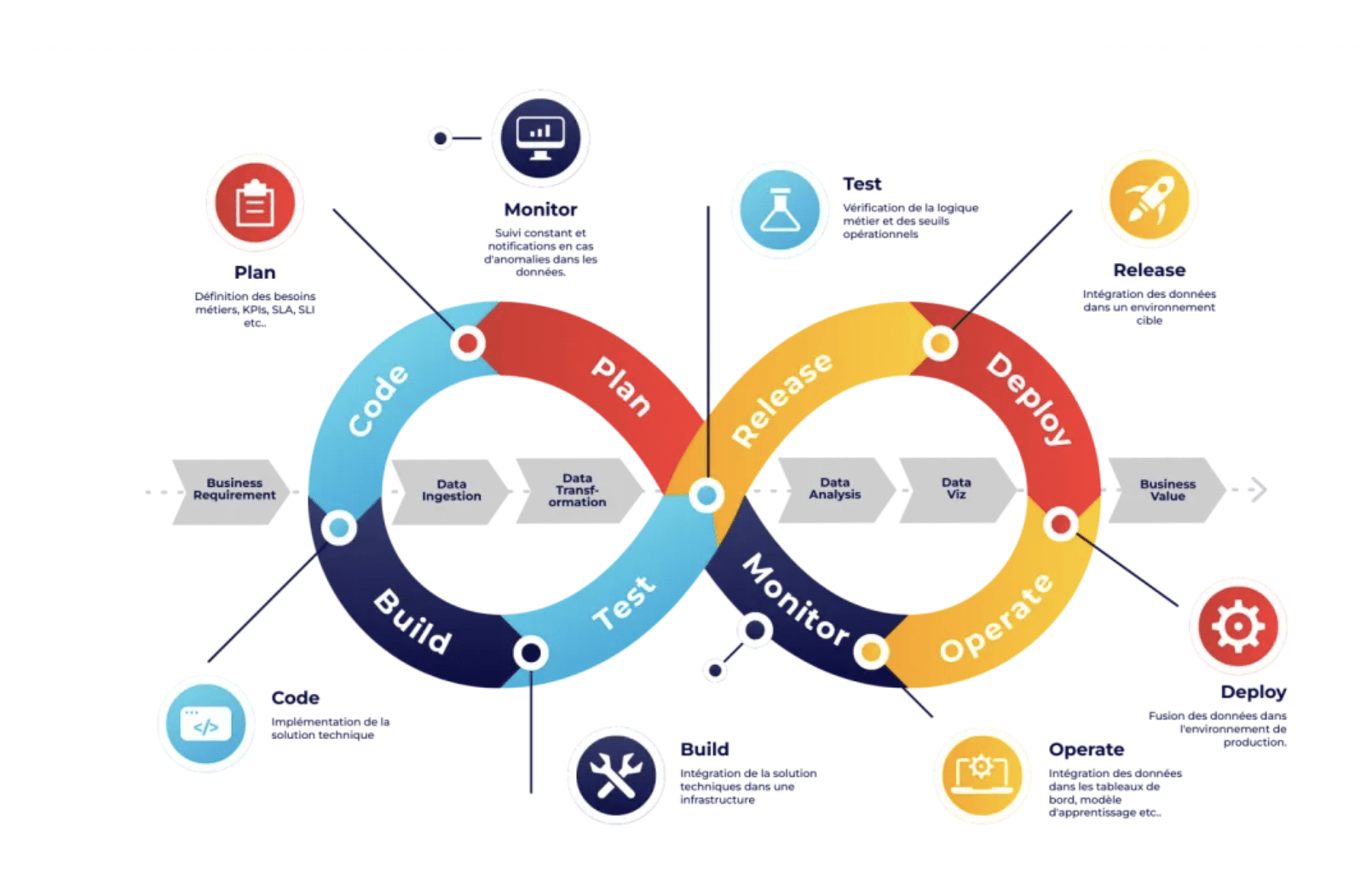

DataOps, una contracción de «Data Operations», redefine la forma en que las empresas procesan sus datos. Al inspirarse en las mejores prácticas de colaboración, automatización e integración continua de DevOps, DataOps no solo acelera los procesos: reúne a equipos de DevOps, científicos de datos e ingenieros de datos para establecer una nueva agilidad en la creación de canales de datos.

Esta coordinación, perfectamente alineada con las necesidades en constante evolución del mercado, también responde a la creciente complejidad de los entornos de datos modernos. Cada paso, desde la recopilación de datos hasta su uso, está optimizado para garantizar velocidad, confiabilidad y flexibilidad.

Los pilares de DataOps: un nuevo enfoque para la gestión de datos

Por definición, DataOps tiene como objetivo mejorar la calidad y reducir el tiempo del ciclo del análisis de datos. Es por eso que uno de los conceptos clave que adopta es la Infraestructura como Código (IaC), tomada de las arquitecturas de nube y sus prácticas de implementación.

Al adoptar IaC, DataOps aporta la misma agilidad y automatización a la gestión de datos, permitiendo definir y gestionar infraestructuras de datos de forma declarativa. Esto facilita la orquestación de procesos de un extremo a otro, garantizando coherencia y repetibilidad en diferentes flujos e implementaciones de ETL.

Pero la fuerza de DataOps no termina ahí. Incorpora un ciclo de vida completo de los datos, que cubre cada paso esencial del proceso:

- Planificación: los equipos empresariales colaboran para definir indicadores clave de rendimiento (KPI).

- Desarrollo: se construyen estos indicadores o modelos de aprendizaje automático.

- Integración: se integran en las pilas de tecnología existentes. Una vez integrados, se someten a pruebas rigurosas para garantizar que cumplan con la lógica empresarial y los criterios operativos. Estas pruebas validan la conformidad de los datos antes de su implementación en producción.

- Lanzamiento: los datos se implementan en un entorno de prueba, antes de pasar a producción en la fase de implementación. Una vez en producción, los datos se utilizan en aplicaciones como Power BI o paneles de Tableau, o para impulsar modelos de aprendizaje automático.

Para garantizar el rendimiento y la fiabilidad de estos KPI de productos, el monitoreo y la observabilidad continuos son esenciales. Permiten detectar anomalías y optimizar las tuberías en tiempo real, garantizando así una calidad impecable en cada etapa.

Lo que hace que DataOps sea particularmente poderoso es su capacidad de escalar. Principios como la modularidad de las tuberías, la seguridad y la automatización se repiten continuamente para adaptarse a las necesidades comerciales cambiantes y los avances tecnológicos.

Implementando DataOps: innovando para gestionar mejor los datos

En Geko y Claranet hemos transformado DataOps en una realidad concreta, combinando innovación y eficiencia para redefinir la gestión de datos.

Infraestructura como Código (IaC): Gracias a herramientas como Terraform, estandarizamos y simplificamos la configuración de proyectos. Esto nos permite desplegar y gestionar entornos complejos de forma ágil, reduciendo errores humanos y centralizando configuraciones. Resultado: colaboración fluida entre equipos y perfecta trazabilidad de las modificaciones.

Automatización de canalización de datos: Nuestros procesos ETL están completamente automatizados, lo que garantiza flujos de datos rápidos, confiables y consistentes. Diseñamos tuberías modulares y reutilizables que aceleran el desarrollo y al mismo tiempo garantizan la coherencia entre los proyectos. Ya sea para cargar lagos de datos o almacenes de datos, cada paso está orquestado para garantizar la continuidad operativa, pero también planificado y capaz de reiniciarse automáticamente si es necesario.

Cadena CI/CD: La integración y la implementación continua están en el centro de nuestra estrategia DataOps. Nuestros canales de CI/CD automatizan las pruebas y las implementaciones. Esto reduce los errores y acelera los ciclos de desarrollo. Con plantillas desarrolladas para diferentes casos de uso, simplificamos y estandarizamos las implementaciones, haciendo que nuestros ingenieros de datos sean más autónomos y eficientes.

Monitoreo continuo y gestión proactiva: Nuestra infraestructura, basada en un diseño “Event Mesh”, funciona como un sistema nervioso central, detectando y gestionando anomalías en un entorno distribuido. Centraliza notificaciones, alertas y las redirige a los servicios de alerta adecuados, al tiempo que activa tickets automáticamente, ya sea en respuesta a una alerta o de forma preventiva. De este modo, cada problema potencial se identifica y resuelve antes de convertirse en un incidente mayor, garantizando un rendimiento óptimo y la continuidad de las operaciones.

Además, la herramienta DataFlow Cockpit, desarrollada por el equipo de análisis de datos, desempeña un papel clave al proporcionar una visión general y granular de cada uno de los canales de datos. Gracias a sus paneles de control que resumen todos los flujos de datos, nuestros clientes pueden visualizar su entorno con gran precisión, al igual que nuestros equipos. De este modo pueden controlar el estado de sus sistemas de forma autónoma.

Seguridad de los datos: Implementamos estrictas prácticas de seguridad, como cifrado y gestión precisa del acceso, para proteger la confidencialidad e integridad de la información. Dependiendo de las necesidades, nuestras infraestructuras pueden disponer de módulos de anonimización y seudonimización para cumplir con los requisitos del Reglamento General de Protección de Datos (GDPR).

Combinando rigor técnico e innovación, ofrecemos a nuestros clientes una gestión de datos sólida y segura. Esto les permite centrarse en aprovechar al máximo sus datos y, al mismo tiempo, minimizar las interrupciones y los riesgos operativos.

Optimización de ejecución: Nuestro enfoque DataOps va más allá de la automatización y el monitoreo proactivo. Aprovecha los datos recopilados en producción para mejorar continuamente nuestros canales de datos. Al examinar el rendimiento en el mundo real, detectamos rápidamente formas de optimizar nuestras soluciones para hacerlas más eficientes y confiables.

Por ejemplo, al monitorear el funcionamiento de nuestros canales de datos en producción, los ajustamos para aumentar su estabilidad y capacidad de escalamiento. Esto permite que nuestros sistemas se adapten naturalmente a las necesidades del cliente manteniendo un alto rendimiento.

Además, desde las fases de diseño, integramos requisitos de producción específicos para asegurar que nuestras arquitecturas de datos estén optimizadas en términos de calidad y rendimiento. Esto no sólo garantiza una implementación fluida, sino que también reduce los ajustes necesarios una vez en producción.

Mirando hacia el futuro: DataOps e IA

DataOps y la Inteligencia Artificial están evolucionando juntas para permitir a las empresas aprovechar sus datos de una manera más ágil e inteligente. Pensemos en Uber, que utiliza Michelangelo para entrenar modelos de aprendizaje automático en GPU distribuidas. Esto optimiza sus operaciones a gran escala.

Netflix, por su parte, utiliza sólidos canales de datos para probar e implementar modelos de recomendación personalizados, lo que aumenta la participación de los usuarios. Por otro lado, Airbnb cruza diferentes fuentes de datos para perfeccionar sus recomendaciones de experiencias, animando a más usuarios a realizar reservas.

Estos ejemplos muestran claramente cómo la combinación de la cultura DataOps y la IA ayuda a las empresas a mantener una ventaja competitiva, adaptándose rápidamente a los cambios y anticipándose a las tendencias.

DataOps está en constante evolución, y sin poder predecir su próxima mutación, seguirá cumpliendo el objetivo de mejorar la confiabilidad, el rendimiento y la agilidad en la explotación de datos en producción y desarrollando usos en torno a esta.

¿Quieres saber más? Contacta con nuestro equipo